L’informatica (IT – Information Technology) ha vissuto una trasformazione radicale nel corso degli ultimi decenni. Dai primi calcolatori di grandi dimensioni usati solo da enti governativi e grandi aziende, fino alle attuali soluzioni in cloud accessibili a chiunque abbia una connessione a internet, il percorso dell’IT è stato segnato da innovazioni straordinarie, salti tecnologici e cambiamenti sociali profondi.

In questo articolo esploreremo in dettaglio l’evoluzione dell’informatica, partendo dai mainframe degli anni ’50 e ’60, passando per l’avvento dei personal computer, l’era di internet, la virtualizzazione, fino ad arrivare alla rivoluzione del cloud computing. Analizzeremo anche le implicazioni di questi cambiamenti e come hanno trasformato il modo in cui lavoriamo, comunichiamo e viviamo.

Indice

L’era dei mainframe: gli albori dell’informatica moderna

L’inizio dell’era dell’informatica moderna può essere tracciato attraverso lo sviluppo e l’adozione dei mainframe, i grandi calcolatori elettronici centrali progettati per elaborare enormi quantità di dati. Questi sistemi, che videro la luce a partire dagli anni Cinquanta, rappresentarono un punto di svolta per la tecnologia dell’informazione. A differenza dei computer moderni a cui siamo abituati, i mainframe erano colossi fisici: occupavano intere stanze, consumavano grandi quantità di energia e necessitavano di complesse infrastrutture di raffreddamento per poter funzionare in maniera stabile.

Erano strumenti estremamente costosi e sofisticati, accessibili solo a grandi organizzazioni come enti governativi, università, eserciti e grandi aziende multinazionali, soprattutto nel settore bancario e assicurativo. L’accesso ai mainframe non era diretto: l’interazione avveniva tramite terminali, dispositivi che permettevano agli utenti di inviare istruzioni al mainframe, che elaborava i dati centralmente e restituiva i risultati in tempi relativamente lunghi, rispetto agli standard odierni. Nonostante queste limitazioni, i mainframe offrivano una potenza di calcolo senza precedenti e venivano utilizzati per operazioni complesse, come la gestione dei conti correnti, la pianificazione militare, le simulazioni scientifiche e l’elaborazione delle tasse.

Questa era gettò le fondamenta per tutto ciò che sarebbe venuto dopo: definì il concetto di elaborazione dati su larga scala, introdusse il modello centralizzato della gestione informatica e contribuì alla formazione delle prime generazioni di specialisti IT. La mentalità e l’architettura sviluppate durante l’epoca dei mainframe avrebbero continuato a influenzare l’industria per decenni, anche mentre la tecnologia si evolveva in forme sempre più distribuite e accessibili.

La rivoluzione del personal computer (PC)

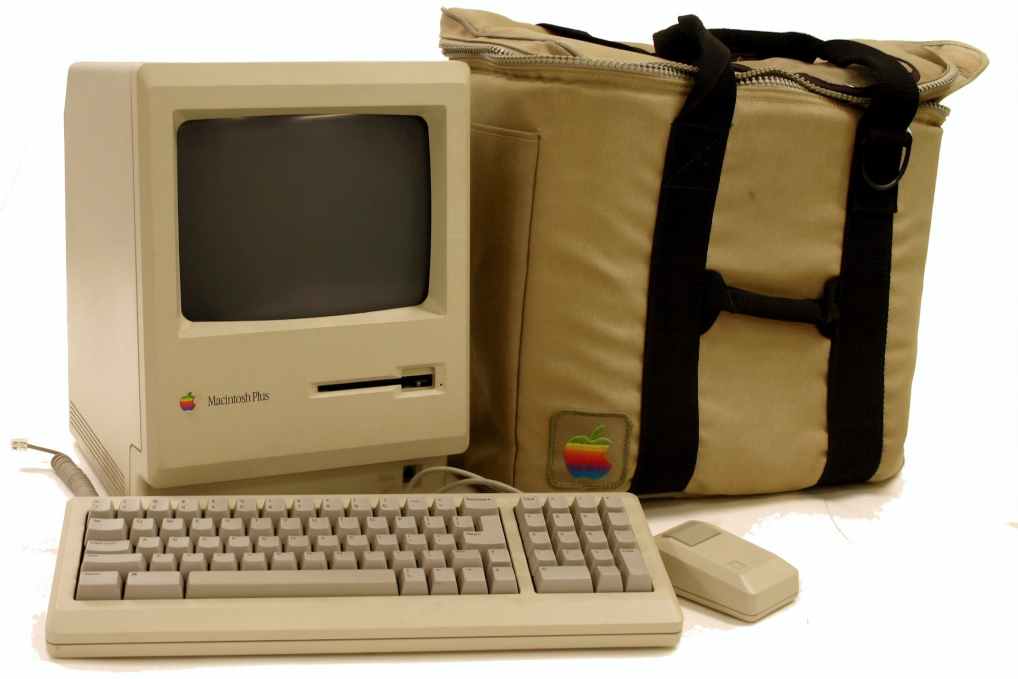

Con l’inizio degli anni Settanta e soprattutto lungo gli anni Ottanta, il panorama dell’IT fu radicalmente trasformato dall’introduzione dei personal computer, una delle più importanti rivoluzioni tecnologiche del ventesimo secolo. Mentre i mainframe rappresentavano un modello centralizzato e elitario, i personal computer introdussero un approccio decentralizzato e democratico all’elaborazione dei dati, rendendo l’informatica accessibile a milioni di persone comuni e a piccole imprese.

Questa rivoluzione fu resa possibile dall’evoluzione dei microprocessori, circuiti integrati sempre più potenti e compatti, in grado di sostituire interi armadi di componenti elettronici. Grazie a questa miniaturizzazione, fu possibile creare macchine economiche, di dimensioni contenute, adatte ad essere collocate su una scrivania. Aziende come Apple, Commodore e IBM furono tra le protagoniste di questa trasformazione. L’introduzione dell’IBM PC nel 1981, in particolare, stabilì uno standard industriale e aprì la strada a una rapidissima diffusione dei computer personali in tutto il mondo.

I personal computer cambiarono non solo il modo in cui si lavorava, ma anche il modo in cui si apprendeva, si giocava e si comunicava. Si passò da un utilizzo tecnico e specialistico dell’informatica a un uso quotidiano e diffuso, che andava dall’elaborazione di testi alla contabilità domestica, dalla grafica digitale ai videogiochi. Anche l’interfaccia utente evolse: le prime GUI, interfacce grafiche a icone e finestre, permisero agli utenti di interagire con il computer senza la necessità di conoscere complicati linguaggi di programmazione. I sistemi operativi come MS-DOS, seguito poi da Windows, e il Macintosh con il suo sistema operativo intuitivo, contribuirono in modo determinante a questa trasformazione culturale.

In sostanza, la rivoluzione del PC rappresentò il momento in cui l’informatica uscì dai laboratori e dai centri dati per entrare nelle case, negli uffici, nelle scuole, cambiando per sempre la percezione e il ruolo della tecnologia nella vita quotidiana.

L’avvento di Internet: la rete che ha cambiato tutto

Se l’introduzione del personal computer rese l’informatica personale, fu l’arrivo di Internet a renderla globale. Negli anni Novanta, l’espansione di Internet rivoluzionò l’intero ecosistema IT, trasformando il computer da uno strumento isolato in una finestra aperta sul mondo. Per la prima volta, milioni di dispositivi sparsi per il pianeta poterono comunicare tra loro in tempo reale, scambiando informazioni, file, immagini, idee. Era l’alba dell’era della connettività permanente.

Internet, nato come progetto militare e accademico con ARPANET negli Stati Uniti, si sviluppò in un’infrastruttura globale che superava ogni confine geografico o politico. Con la nascita del World Wide Web nel 1991, grazie al lavoro di Tim Berners-Lee, si aprirono nuove possibilità di accesso e condivisione delle informazioni, rese ancora più accessibili con i primi browser grafici come Mosaic e Netscape. La navigazione tra siti web divenne un’attività alla portata di chiunque, stimolando un’esplosione di contenuti e servizi digitali.

Le conseguenze dell’avvento di Internet furono profonde e durature. Il concetto di tempo e distanza fu radicalmente ridimensionato: comunicare con una persona all’altro capo del mondo divenne istantaneo e gratuito, grazie all’email e ai sistemi di messaggistica. Le aziende iniziarono a creare siti web, vendere prodotti online, offrire servizi digitali: nacquero nuovi modelli di business, come l’e-commerce, il marketing digitale, la pubblicità online. Anche il mondo del lavoro e dell’istruzione iniziò a cambiare, con le prime forme di telelavoro e apprendimento a distanza.

Dal punto di vista tecnico, l’informatica cominciò ad adottare nuove architetture distribuite: il modello client-server, in cui i dati e le applicazioni risiedevano su server remoti accessibili via rete, divenne la norma. La programmazione web, l’utilizzo di database relazionali accessibili tramite interfacce web, e la nascita di linguaggi come JavaScript e PHP permisero di costruire applicazioni sempre più complesse e interattive.

In definitiva, Internet rappresentò una cesura storica. Dopo il suo avvento, l’informatica non fu più la stessa: smise di essere una disciplina chiusa e tecnica per diventare un tessuto connettivo della società moderna, capace di influenzare profondamente cultura, economia, politica e relazioni umane.

La virtualizzazione e il data center moderno

L’inizio degli anni Duemila segnò un’altra svolta significativa nel mondo dell’informatica: l’introduzione e la diffusione della virtualizzazione. Questo concetto rivoluzionario permise di superare i limiti fisici dell’hardware, aprendo la strada a una gestione delle risorse più efficiente, flessibile e scalabile. Prima della virtualizzazione, ogni server fisico era dedicato a una singola applicazione o funzione. Questo approccio portava a un notevole spreco di risorse, poiché molte macchine operavano al di sotto della loro capacità reale.

La virtualizzazione cambiò radicalmente questa logica. Attraverso software noti come hypervisor, fu possibile creare più ambienti virtuali – detti macchine virtuali – all’interno dello stesso hardware fisico. Ogni macchina virtuale poteva funzionare come se fosse un computer a sé stante, con il proprio sistema operativo, le proprie applicazioni e la propria configurazione. Ciò consentì alle aziende di consolidare i propri server, ridurre i costi legati all’infrastruttura e semplificare la gestione dei sistemi.

I data center, cioè i centri dove vengono ospitati e gestiti i sistemi informatici aziendali, cominciarono a trasformarsi: da ambienti rigidi e sovradimensionati, diventarono strutture dinamiche e ottimizzate, capaci di adattarsi rapidamente alle esigenze del business. La virtualizzazione rese anche più semplice la realizzazione di soluzioni di backup e disaster recovery, poiché una macchina virtuale poteva essere replicata, spostata o riavviata su un altro host in modo molto più semplice rispetto a un server fisico tradizionale.

Nel contesto dei data center moderni, l’intero stack tecnologico cominciò ad essere virtualizzato: non solo i server, ma anche il networking e lo storage. Nasceva così il concetto di “software-defined data center”, in cui tutte le componenti fisiche venivano astratte e gestite tramite software, creando un’infrastruttura IT altamente automatizzata e orchestrata. Questo processo di smaterializzazione dell’hardware rappresentò un passaggio cruciale verso il modello successivo: il cloud computing.

Il cloud computing: la nuova frontiera dell’IT

Con il consolidarsi della virtualizzazione, si aprì la strada a una nuova fase dell’informatica, ancora più rivoluzionaria: il cloud computing. Questo paradigma trasformò ulteriormente il modo in cui si pensava, si progettava e si utilizzava l’infrastruttura IT. Il cloud introdusse un modello di fruizione delle risorse basato sull’accesso remoto tramite internet, consentendo agli utenti di utilizzare server, archivi di dati, applicazioni e servizi senza doversi preoccupare della gestione diretta dell’hardware sottostante.

Il cloud computing si basa su un’idea semplice ma potentissima: offrire risorse IT come un servizio. In altre parole, anziché acquistare e mantenere i propri server, un’azienda poteva affittare la potenza di calcolo di cui aveva bisogno da un provider cloud, pagando solo per l’uso effettivo. Questo modello, spesso definito “pay-per-use”, ridusse drasticamente i costi iniziali legati all’infrastruttura e rese l’IT molto più accessibile anche a startup e piccole imprese.

Ma i vantaggi del cloud non si limitano ai costi. Grazie alla scalabilità automatica, le risorse possono essere aumentate o diminuite in tempo reale, in base alla domanda. Questo rende il cloud ideale per ambienti dinamici e imprevedibili. Inoltre, i fornitori di servizi cloud offrono aggiornamenti continui, sicurezza avanzata, ridondanza geografica e strumenti per la gestione dei dati e delle applicazioni su scala globale.

Le soluzioni cloud si sono articolate in diverse forme, ognuna con un grado diverso di controllo e responsabilità: dall’infrastruttura come servizio (IaaS), che fornisce risorse grezze come server virtuali e spazio di archiviazione, alle piattaforme come servizio (PaaS), che permettono agli sviluppatori di costruire applicazioni senza preoccuparsi dell’ambiente sottostante, fino al software come servizio (SaaS), dove gli utenti accedono direttamente a strumenti applicativi tramite il browser.

Nonostante i suoi numerosi benefici, il cloud ha sollevato anche nuove sfide, in particolare sul fronte della sicurezza e della privacy. Affidare i propri dati a terze parti comporta dei rischi, specialmente in settori regolamentati. Per questo motivo, si sono sviluppati modelli ibridi, che combinano il cloud pubblico con risorse private, offrendo maggiore controllo e flessibilità.

Il cloud ha trasformato l’IT in un servizio fluido, accessibile ovunque e in qualsiasi momento. Ha ridisegnato il ruolo dell’infrastruttura e ha aperto le porte a nuovi modelli operativi, come il DevOps, il CI/CD e l’IT as Code. In un certo senso, ha completato quel percorso di smaterializzazione iniziato con la virtualizzazione, portando l’informatica a diventare una vera e propria utility, come l’elettricità o l’acqua.

Verso il futuro: AI, edge computing e quantum computing

Mentre il cloud computing continua a consolidarsi come lo standard dell’informatica moderna, all’orizzonte si profilano nuove tecnologie destinate a cambiare ancora una volta il volto dell’IT. Tra queste, spiccano l’intelligenza artificiale, l’edge computing e il quantum computing, ognuna delle quali introduce paradigmi profondamente diversi, con potenzialità enormi.

L’intelligenza artificiale (AI) non è più una promessa futuristica, ma una realtà concreta che già oggi sta trasformando interi settori. Algoritmi di machine learning e deep learning sono ormai utilizzati in ambiti che spaziano dalla diagnostica medica all’automazione industriale, dalla guida autonoma all’analisi predittiva nei mercati finanziari. L’AI permette alle macchine di apprendere dai dati, adattarsi ai cambiamenti e prendere decisioni complesse, ridefinendo i limiti dell’automazione. Le imprese che adottano queste tecnologie riescono ad ottenere vantaggi competitivi significativi, grazie a processi decisionali più rapidi, personalizzazione dei servizi e anticipazione delle tendenze di mercato.

Parallelamente, l’edge computing sta emergendo come risposta alla crescente mole di dati generati dai dispositivi connessi, come sensori, telecamere, dispositivi indossabili e veicoli intelligenti. Invece di inviare tutte queste informazioni al cloud per essere elaborate, l’edge computing prevede che l’elaborazione avvenga localmente, “sul bordo” della rete, vicino alla fonte del dato. Questo approccio riduce la latenza, migliora la reattività dei sistemi e alleggerisce il traffico di rete, rendendolo ideale per applicazioni in tempo reale come la realtà aumentata, la robotica, la manutenzione predittiva e l’Internet delle Cose (IoT).

Infine, il quantum computing rappresenta la prossima frontiera della scienza informatica. Basato su principi della meccanica quantistica, il calcolo quantistico promette di superare di gran lunga le capacità dei computer classici nella risoluzione di problemi complessi, come la simulazione di molecole per la progettazione di nuovi farmaci, l’ottimizzazione logistica o la crittografia. Anche se ancora in fase sperimentale, le ricerche stanno avanzando rapidamente, e i prototipi di computer quantistici sono già in grado di eseguire calcoli che sarebbero proibitivamente lenti per qualsiasi supercomputer esistente.

In definitiva, l’evoluzione dell’IT non si è fermata: continua ad accelerare, spinta da innovazioni che sfidano costantemente i limiti di ciò che è possibile. L’informatica del futuro sarà sempre più intelligente, distribuita e potente, ma anche sempre più responsabile: le questioni etiche, ambientali e sociali legate all’uso della tecnologia diventeranno centrali, e spetterà a noi decidere in che direzione guidare questo straordinario viaggio.

Conclusione

L’evoluzione dell’IT non è solo una storia di progresso tecnologico, ma anche un riflesso della trasformazione della società. Dai mainframe centralizzati ai servizi cloud distribuiti, ogni fase ha ridefinito ciò che è possibile.

Nel mondo odierno, in cui tutto – dal lavoro alla sanità, dall’educazione all’intrattenimento – dipende dall’IT, comprendere questa evoluzione è fondamentale. Il futuro sarà definito da come sapremo integrare tecnologie emergenti in modo responsabile, sostenibile e inclusivo.

Fondamenti di tecnologie dell’informazione

- Introduzione alla tecnologia dell’informazione: cosa comprende?

- La differenza tra l’information technology (IT) e l’informatica teorica (Computer Science)

- Il ruolo degli esperti IT nel business moderno

- Come funziona un sistema informativo?

- Infrastruttura dei sistemi IT – cosa comprende?

- L’evoluzione dell’IT: dai mainframe al cloud

- Hardware vs Software: Differenze fondamentali ed esempi

- Sistemi operativi: Windows, macOS, Linux – panoramica completa

- Basi di dati: Cosa sono e come si usano

- Il ciclo del software: dall’idea all’implementazione